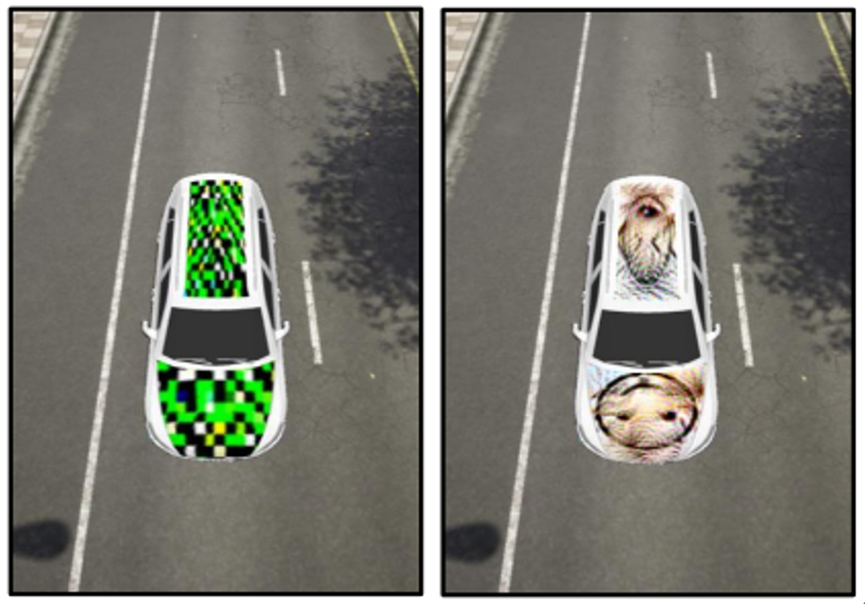

下面两张图中,同样是添加涂装的汽车,人工智能模型却会将右图识别成老鼠,难道是贴纸材料暗藏玄机?

[1] Wang J, Liu A, Yin Z, et al. Dual attention suppression attack: Generate adversarial camouflage in physical world[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 8565-8574.

对人眼来说,这两张图都是普通的添加涂装的车辆。但事实上,左边这张图中车上如涂鸦般的纹理,是人为精心设计出的对抗纹理,这种纹理导致一个普通的人工智能模型将道路上的车辆误识别为其他物体。

像这种直接在物体上增加不影响人类识别的纹理,使AI模型接受并做出错误的判断的攻击手段,就是物理世界中对深度神经网络最常用的对抗攻击方法之一。

这种看上去像涂鸦的对抗攻击方法虽然成本低廉,但危害可不小。目前,AI模型已经开始应用于自动驾驶领域,如果因为对抗攻击,自动驾驶汽车误将红灯识别为绿灯,将路障识别为可通行标志,甚至无法检测到前方的行人与汽车,后果将不堪设想。

构建安全、鲁棒的AI模型,促使其能够应对物理世界场景下的对抗攻击,在人工智能领域日趋重要。

然而,当前很多AI模型是在封闭数据集下进行训练,无法适应开放世界场景,多样性的噪声与对抗补丁数据将会给模型案例及鲁棒性带来极大挑战。

为了加速物理世界自动驾驶场景下的鲁棒模型研究,推动新的以数据为中心的算法开发,北京航空航天大学联合商汤科技、合肥综合性国家科学中心数据空间研究院,举办面向物理开放场景的车辆目标检测安全挑战赛——Vehicle Detection in the Physical-World。本次大赛由OpenI启智社区提供算力资源支撑选手们完成比赛。

北航刘祥龙教授团队多年来深耕人工智能安全领域,不断探索可信赖人工智能前沿技术,在对抗攻防、模型评测和可解释理论方面成果丰硕,在国内外均有一定影响力。

本次大赛依托CVPR 2023的workshop“The 3rd Workshop of Adversarial Machine Learning on Computer Vision: Art of Robustness”展开,希望鼓励研究者开发面向物理世界的鲁棒检测算法,以自动驾驶作为典型应用场景,在复杂的真实世界场景及多样化的对抗攻击算法等因素下,探究鲁棒模型的生产方式,促进鲁棒检测模型的发展。

此外,比赛获奖队伍还将受邀在workshop中做分享,讲解自己的技术方案。大赛已经正式启动,查看文末网址,即刻报名参与。

这次的鲁棒车辆检测比赛分为两个阶段。

Phase 1:初级对抗环境车辆检测

初赛阶段,比赛会分别释放训练集和测试集,参赛者可以使用该阶段释放的训练集以及其他任何训练集训练鲁棒目标检测模型。训练集为正常的检测数据,测试集包含正常检测数据和攻击样本。

第一赛道的攻击样本包括5个基础场景、4种取样角度以及3种天气下,通过对抗攻击产生的对抗样本。选手需要得到足够鲁棒的检测模型,能够对干净样本和对抗样本中的车辆进行正确检测。初赛阶段选手需要将给定测试集的预测结果提交。

Phase 2:高级对抗环境车辆检测

复赛阶段,参赛者同样可以使用该阶段释放的训练集与其他任意训练集训练鲁棒模型。但与初赛不同的是,参赛者需要提交训练好的原始模型,平台将对提交的模型进行评测。数据集的构成上,初赛共包含100+种细分场景,复赛则包含400+类,对于所训练模型的泛化检测能力有着更高的要求。

▎比赛时间

3月28日-5月31日

▎比赛奖励

本次比赛总奖池7万人民币。

其中,比赛取前10名,前六名奖金分别为20000、15000、10000、9000、6000、4000元,第七至十名奖金均为1500元;

具体比赛规则及介绍,请前往官网。欢迎对AI模型安全感兴趣的朋友,踊跃报名参加~

▎比赛报名官网

aisafety.sensetime.com

Workshop地址:

北航刘祥龙教授团队介绍:

xlliu-beihang.github.io

Openi启智社区:

https://openi.pcl.ac.cn/

扫描下方二维码,加入CVPR 2023竞赛交流群~