脑机接口重大突破!华裔科学家首次用AI直接从大脑合成语音

AI 构建神经解码器

随着科技的发展,失去说话能力的人已经可以通过技术手段来进行交流,不过,这些技术依然需要他们做一些微小的动作,来控制在屏幕上选择字母或单词的光标。患有运动神经元疾病的英国物理学家斯蒂芬霍金就是一个例子。

现在,利用人工智能技术,科学家或许可以让丧失语言能力的人开口“讲话”。

这个听上去有些天方夜谭的事情,近期在加州大学旧金山分校成功实现了,研究负责人 Edward Chang 表示:“为严重言语残疾患者创造恢复沟通的技术是一项长期目标。这项研究提供了原理证明:可以从大脑活动中产生语音,特别是大脑的语音中心。”

注:Edward Chang 博士是加州大学旧金山分校的神经外科医生,专门治疗顽固性癫痫,三叉神经痛和脑肿瘤。他的研究重点是人类言语、运动和认知的大脑机制。他还是加州大学伯克利分校和加州大学旧金山分校的神经工程与假肢中心的联合负责人,该中心汇集了工程,神经科学,神经科和神经外科,以开发最先进的生物医学设备,以恢复神经残疾患者的功能。

在文章中,Chang 对这项研究的进展进行了详细地解析。

他解释说,使用脸颊肌肉激活的发声装置的人必须逐字逐句地打印单词,所以这些设备的速度非常慢,每分钟最多能打印 10 个单词,而普通人的自然口语速度为平均每分钟 150 个单词。所以,Edward Chang 和他的团队决定在构建神经解码器时对声音系统进行建模。

研究人员在参与者的头骨中植入与这些类似的电极来记录他们的大脑信号

这项实验的参与者,是 5 位正在加州大学旧金山分校医疗中心接受侵入性治疗的癫痫患者。治疗方式是将手掌大小的电极板直接植入在他们的大脑表面上,患者癫痫发作后,电极可以在大脑中发生的地方产生定位。一旦医生确定了发病点,就可以通过移除大脑的病变部分以永久停止癫痫的发作。

当然,除了治疗癫痫之外,这块电极还有一些其他作用,即捕捉语言相关的脑信号。

首先,参与者需要大声朗读数百个句子,此时的大脑活动会被研究人员记录下来,并确定哪些信号控制了所谓的发声器官,包括嘴唇、舌头、下颌、喉头以及人们在没有意识到的情况下移动的嘴和喉咙的其他部位。通过参与者足够的脑信号数据,科学家们能够创建一个计算机模拟的声道。

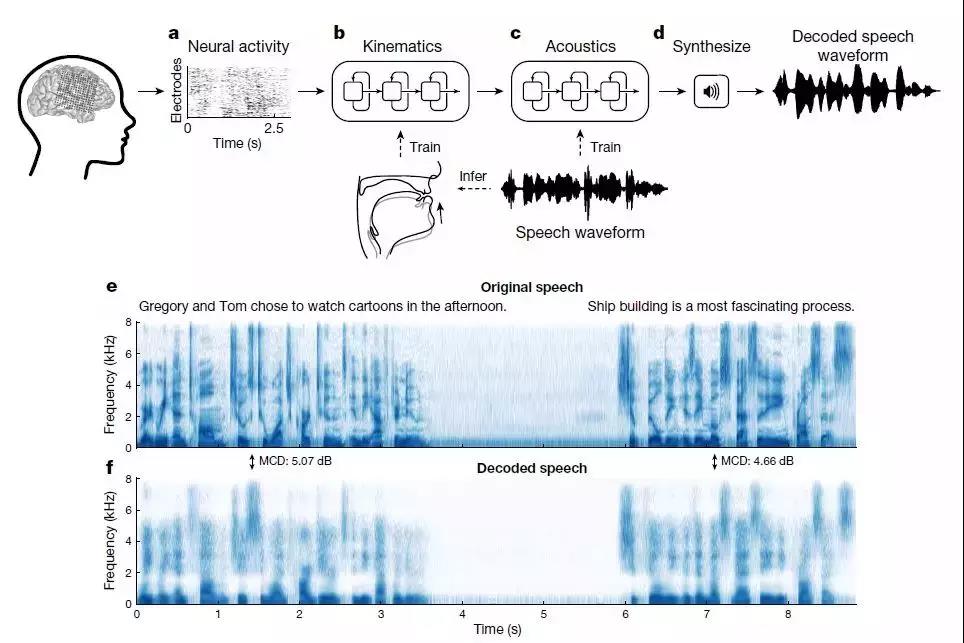

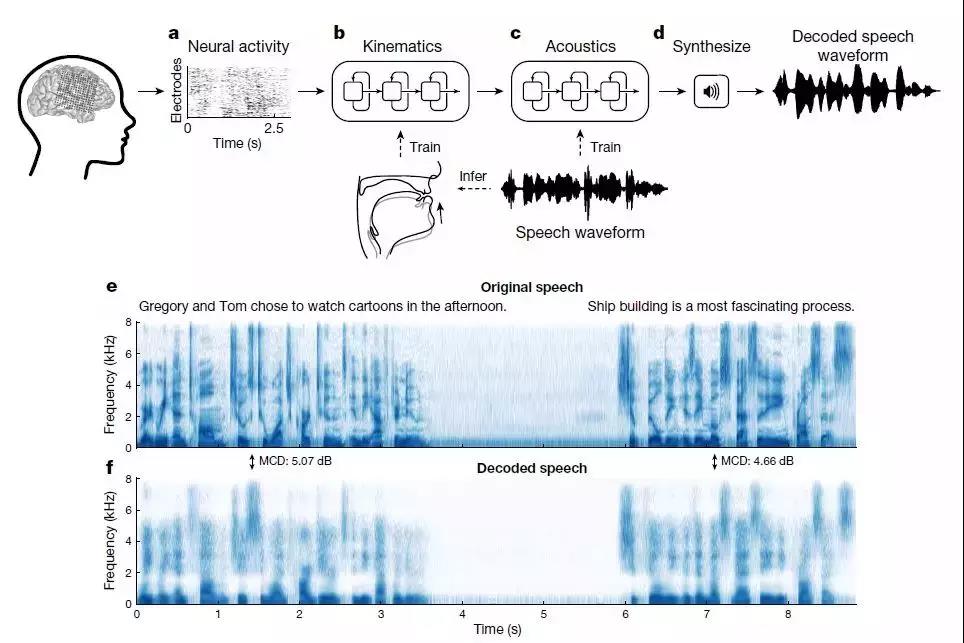

研究人员设计了一种循环神经网络(RNN),可以将记录的皮质神经信号转化为声道咬合关节运动,然后将这些解码的运动转化为口语句子。

研究小组对这些数据进行了深度学习算法的训练,然后将程序整合到解码器中。

很长一段时间以来,脑机交互被认为是计算机与脑科学发展的完美结合,无数科学家也在这一领域进行不懈的探索。

多年前,一位名叫 Phil Kennedy 的神经科学家曾经研究出了一种名为亲神经电极的技术,这种技术可以让电极长时间植入人脑,让脑机接口有可能从实验投入实际使用。1998 年,Phil Kennedy 找到了一位合适的实验对象,通过植入电极,实现了让这位曾经是植物人的瘫痪患者可以用意识打字。

但是由于后续的实验遭遇了接连的失败,接受实验的患者要么伤口长期不能愈合,要么因为身体原因去世。Phil Kennedy 甚至在 2014 年在自己的身上进行了实验,最后却还是出现了伤口无法愈合的情况,最后以失败告终。

而就在不久前,特斯拉 CEO 埃隆·马斯克曾在推文中提到自己的公司 Neuralink 正在研发一种技术,能够利用超小型植入式芯片,有效地将人类的大脑与计算机进行连接。马斯克表示:“Neuralink 的长期目标,就是要实现与人工智能的共存,从而实现一种智能的民主化,确保这种技术在研发成功之后,人工智能将不再是政府和大型企业所垄断的纯数字形式。”

值得一提的是,据知情人士透露,马斯克的这家公司与 Edward Chang 的团队似乎在实验项目上有不少的合作,Chang 团队此次的实验进展,似乎也得到了马斯克方面的帮助。

自计算机出现以来,人们对于脑机接口就开始了漫长的追求,虽然 Edward Chang 和团队的研究带来了新的希望,但是他本人也表示,目前这项功能只存在于实验室中,尚不能在现实中使用。

从原理上来说,Chang 团队所做的工作并不是彻底将思想转化为语言,而是通过捕捉人们发声时候各个器官以及脑信号的活动,再将其合成语音,播放出来。

该团队也明确表示:第一个成功的模型是在可以说话的人身上试验成功的,至于是否会对失去语言能力的人有所帮助,尚有待发掘。

如果有读者对该项研究感兴趣,可以查看相关论文:

https://www.nature.com/articles/s41586-019-1119-1

来源:AI前线

策划&编辑:Natalie

整理:Vincent